САМООРГАНИЗАЦИЯ

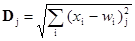

В работе [3] описывались интересные и полезные результаты исследований Кохонена на самоорганизующихся структурах, используемых для задач распознавания образов. Вообще эти структуры классифицируют образы, представленные векторными величинами, в которых каждый компонент вектора соответствует элементу образа. Алгоритмы Кохонена основываются на технике обучения без учителя. После обучения подача входного вектора из данного класса будет приводить к выработке возбуждающего уровня в каждом выходном нейроне; нейрон с максимальным возбуждением представляет классификацию. Так как обучение проводится без указания целевого вектора, то нет возможности определять заранее, какой нейрон будет соответствовать данному классу входных векторов. Тем не менее это планирование легко проводится путем тестирования сети после обучения. Алгоритм трактует набор из n входных весов нейрона как вектор в n- мерном пространстве. Перед обучением каждый компонент этого вектора весов инициализируется в случайную величину. Затем каждый вектор нормализуется в вектор с единичной длиной в пространстве весов. Это делается делением каждого случайного веса на квадратный корень из суммы квадратов компонент этого весового вектора. Все входные вектора обучающего набора также нормализуются и сеть обучается согласно следующему алгоритму: 1. Вектор Х подается на вход сети. 2. Определяются расстояния D j (в n- мерном пространстве) между Х и весовыми векторами W j каждого нейрона. В евклидовом пространстве это расстояние вычисляется по следующей формуле

где х i – компонента i входного вектора X, w ij – вес входа i нейрона j. 3. Нейрон, который имеет весовой вектор, самый близкий к X, объявляется победителем. Этот весовой вектор, называемый W c, становится основным в группе весовых векторов, которые лежат в пределах расстояния D от W c. 4. Группа весовых векторов настраивается в соответствии со следующим выражением: W j(t +l) = W j(t) + a[ X – W j(t)] для всех весовых векторов в пределах расстояния D от W c 5. Повторяются шаги с 1 по 4 для каждого входного вектора. В процессе обучения нейронной сети значения D и a постепенно уменьшаются. Автор [3] рекомендовал, чтобы коэффициент a в начале обучения устанавливался приблизительно равным 1 и уменьшался в процессе обучения до 0, в то время как D может в начале обучения равняться максимальному расстоянию между весовыми векторами и в конце обучения стать настолько маленьким, что будет обучаться только один нейрон. В соответствии с существующей точкой зрения, точность классификации будет улучшаться при дополнительном обучении. Согласно рекомендации Кохонена, для получения хорошей статистической точности количество обучающих циклов должно быть, по крайней мере, в 500 раз больше количества выходных нейронов. Обучающий алгоритм настраивает весовые векторы в окрестности возбужденного нейрона таким образом, чтобы они были более похожими на входной вектор. Так как все векторы нормализуются в векторы с единичной длиной, они могут рассматриваться как точки на поверхности единичной гиперсферы. В процессе обучения группа соседних весовых точек перемещается ближе к точке входного вектора. Предполагается, что входные векторы фактически группируются в классы в соответствии с их положением в векторном пространстве. Определенный класс будет ассоциироваться с определенным нейроном, перемещая его весовой вектор в направлении центра класса и способствуя его возбуждению при появлении на входе любого вектора данного класса. После обучения классификация выполняется посредством подачи на вход сети испытуемого вектора, вычисления возбуждения для каждого нейрона с последующим выбором нейрона с наивысшим возбуждением как индикатора правильной классификации. Литература 1. Grossberg S. 1974. Classical and instrumental learning by neural networks. Progress in theoretical biology, vol. 3, pp. 51–141. New York: Academic Press. 2. Hebb D. O. 1949. Organization of behavior. New York: Science Editions. 3. Kohonen T. 1984. Self–organization and associative memory. Series in Information Sciences, vol. 8. Berlin: Springer verlag. 4. Rosenblatt R. 1959. Principles of neurodynamics. New York: Spartan Books. 5. Widrow B. 1959 Adaptive sampled–data systems, a statistical theory of adaptation. 1959. IRE WESCON Convention Record, part 4. New York: Institute of Radio Engineers. 6. Widrow В., Hoff M. 1960. Adaptive switching circuits. I960. IRE WESCON Convention Record. New York: Institute of Radio Engineers.

|

,

,